NVIDIA Deep learning workshop. 하버드 빅데이터 클럽

NVIDIA Deep learning workshop 참석 후기

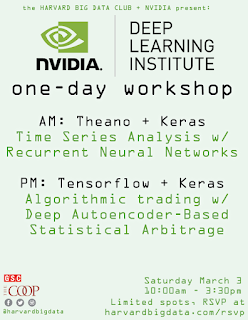

지난 3월 3일에 하버드 Science Center, A hall에서 열린 Deep learning seminar에 다녀왔다. 하버드 빅데이터 클럽이 주관했고, Deep learning을 이끌어 나가는 NVIDIA에서 직접 엔지니어들이 와서 수업을 해 주었다. 수업은 총 2가지로, 하나는 전자보건정보(Electric health record data)를 다루는 session, 하나는 금융정보(Financial data)를 다루는 수업이었다.

하버드라 그런지는 모르겠지만, 스탠포드와는 다르게 정말 전통적이고 이론이 잘 확립 된 통계학을 주로 배웠다. 특히 Observational study를 다룰 때는 통계학적 기법보다는 Confounding, Collider 및 이와 관련한 DAG 등 좀 더 interpretation에 집중한 경향이 있었다. 그래서 요새 hot한 deep learning을 배울 기회는 많이 없었다. 그래서 이번 special session은 너무나 고마운 경험이었다.

|

| 오늘의 Schedule |

NVIDIA라는 기업에 대해서는 아는 게 없었는데, 정말 대단한 회사였다. Deep learning을 다루는 데 기본이 되는 GPU를 독점 생산하는 기업... Moore's law를 뛰어넘는 GPU... Bitcoin 채굴과 더불어 급성장한 기업... 그리고 아마 data science를 이끌어나갈 선두에 선 기업이 아닌가 싶었다. 마치 삼성이 반도체를 기반으로 휴대폰 시장을 선점한 것 처럼... 이 회사는 GPU 생산능력을 기반으로 데이터 분석 시장을 선점하듯이...

|

| 3월에 열릴 NVIDIA workshop에 대한 홍보. Deep learning 하는 사람들이면 다 여기 온다고 한다. |

1. Electronic Health Record Data

- LSTM/ Keras/ Theano (좀 느려졌다) / CNN (Convolution network 등)- Image 처리 / RNN(Recurrent neural network)

- RNN : Recurrent Neural Network: similar to traditional feed-forward network.

-> good for time series analysis. We can look back time. But, vanishing gradient problem

=> Remedy: LSTM: Long short term memory // LSTM can learn very deep tasks. (KERAS RNN)

- RNN : Recurrent Neural Network: similar to traditional feed-forward network.

-> good for time series analysis. We can look back time. But, vanishing gradient problem

=> Remedy: LSTM: Long short term memory // LSTM can learn very deep tasks. (KERAS RNN)

- KERAS(Not techniically a framework): Runs on TensorFlow and Theano, Theano excels ast RNNs / LSTMs

[Extra information]

= Andrej Karapathy and Andrew Ng

= cs 231n

= Andrej Karapathy and Andrew Ng

= cs 231n

2. Algorithm Trading using Statistical Arbitrage with Deep Autoencoders

- Autoenconders

- Anomaly detection

- Algorithmic trading using statistical arbitrage with deep autoencoders

reconstruction error(difference between input and output<- generated by the network)를 본다.

<Autoencoder>

PCA와 비슷하다, latent features

- Aurelien Geron, Hands-on Machine Learning with Scikit-Learn and Tensorflow

- Image clustering for labeling, Image generation, Anomaly detection

PCA와 비슷하다, latent features

- Aurelien Geron, Hands-on Machine Learning with Scikit-Learn and Tensorflow

- Image clustering for labeling, Image generation, Anomaly detection

=== mean reverting strategy ===

1) Moving average - mean reversion

- back testing, data, performance evaluation, hyperparameters

- back testing, data, performance evaluation, hyperparameters

* Dataset

T R1 R2 R3 R4 R5 R6 R7

1

2 . . . . . . . .

3 . . . .

4 . . . .

T R1 R2 R3 R4 R5 R6 R7

1

2 . . . . . . . .

3 . . . .

4 . . . .

* Hyperparameter

T1: threshold to enter a position

T2: threshold to exit a position <<- 요새는 이 Hyperparameter를 bayesian inference로 구하려고도 한다.

Number of layers in deep autoencoder

Historical data window

Window for residual analysis

T1: threshold to enter a position

T2: threshold to exit a position <<- 요새는 이 Hyperparameter를 bayesian inference로 구하려고도 한다.

Number of layers in deep autoencoder

Historical data window

Window for residual analysis

-----------------------------------------------------------------------------------------

<느낀 점>

1. Electronic Health Record Data를 다룰 때, 수많은 covariate를 confounding, collider에 대한 논의 없이 한번에 independent variable로 집어넣는 것을 보고 경악했다... 하지만 수많은 covariates를 N - dimensional space에 두지 않고, image로 처리해서 dependent variable을 구하는 것은 괭장히 cool했다.

2. Financial data를 다룰 때, 사실 moving average를 통해서 algorithm을 짜는 건 옛날 방식이다. 하지만 이번 session의 implication은 "latent feature를 이용하여 anomalies를 찾는다"에 있다. 다만 deep learning에서 사용하는 알고리즘답게 어떠한 데이터가 어떻게 영향을 미치는 지는 알 수 없다.

댓글

댓글 쓰기